WWDC25で発表された、Apple Intelligenceの新機能

- 藤崎 翔太

- 2025年6月10日

- 読了時間: 5分

更新日:2025年9月1日

開発者はデバイス上のApple Intelligence基盤モデルにアクセスしてアプリへの組み込みが可能

Apple Intelligenceと他社生成AIの大きな違いは、ローカル環境で生成AIが動作するという点だ。これはどういうことを意味するのか?

Apple Intelligenceの主なメリット

プライバシーの確保によるユーザーの信頼獲得

Appleのデバイス上で処理が完結するため、ユーザーの個人情報やセンシティブなデータがクラウドに送信されない。

アプリ側もユーザーの信頼を得やすく、「データはデバイス上のみで処理」と伝えることでプライバシー重視ユーザーの取り込みが可能。。

ネットワーク依存の排除

オフラインや通信環境が悪い状況でも生成AI機能が利用できる。

応答速度が速く、UX(ユーザー体験)の向上につながる。

インフラ構築不要でコスト削減

他の生成AI(例:OpenAI APIやAWS Bedrockなど)は外部サーバー利用が前提であり、APIコストやインフラ整備が必要。

Apple Intelligenceを使えば、Appleデバイス上で直接処理されるため、クラウド利用コストや遅延の心配が少ない。

ただし、Appleのエコシステム外(AndroidやWindows)への展開は難しい。また、実際にどの程度の処理がローカルで可能か、どの機能がAPI化されるかは、今後のWWDCや開発者向け情報次第である。今回発表された機能には以下のものがある。

ライブ翻訳

ユーザーが異なる言語でコミュニケーションする際、ライブ翻訳を利用するとメッセージ送信や会話で言語を超えてやり取りできる。この機能はメッセージ、FaceTime、電話に組み込まれており、Appleのデバイス上で動作するモデルで処理されるため、ユーザーの会話のプライバシーが保たれる。

メッセージアプリでは、入力したメッセージが自動で翻訳され、相手の言語で送信される。返信もすぐに翻訳される。FaceTimeでは、話し手の声を聞きながら翻訳されたライブキャプションで会話内容を把握できる。電話通話では、会話全体が翻訳され音声で読み上げられる。

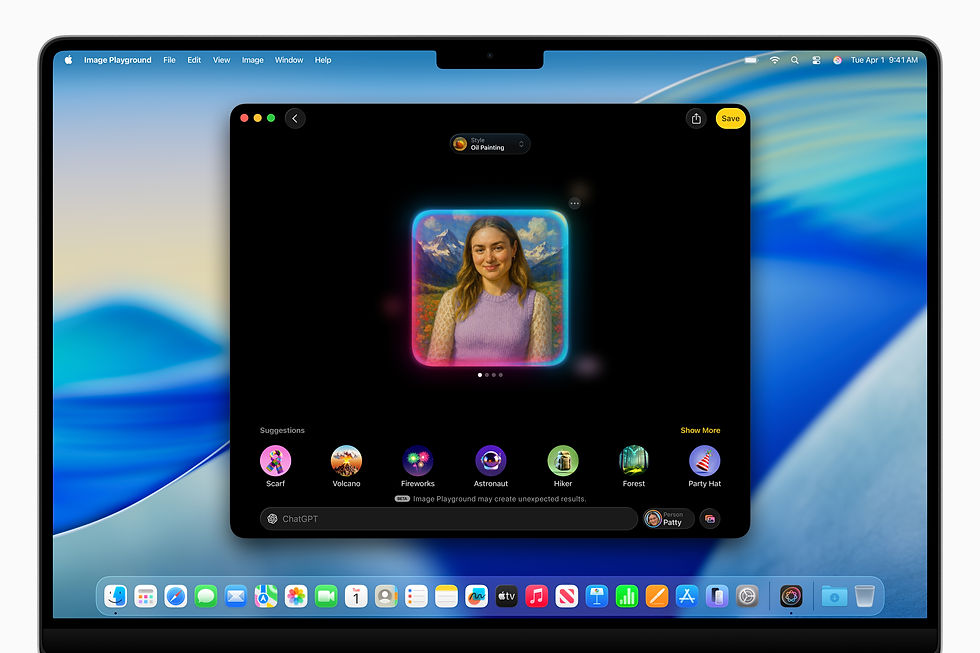

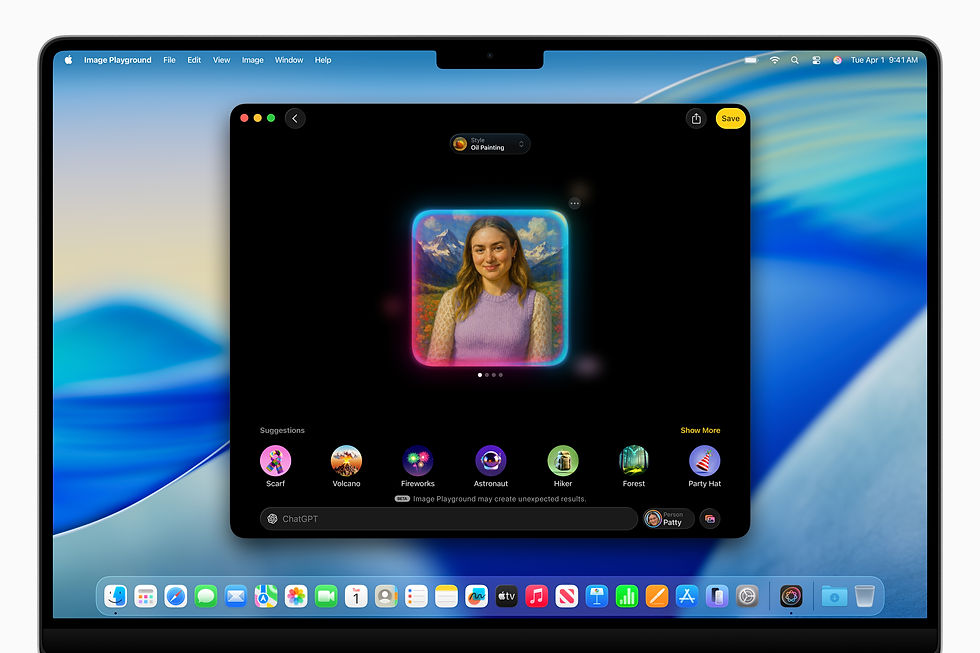

ジェン文字とImage Playgroundによる表現機能

ジェン文字とImage Playgroundは、ユーザーに多様な自己表現の方法を提供する。テキストをジェン文字に変換し、絵文字を組み合わせて新しい表現を作れる。これらを使い、家族や友人から得たインスピレーションをもとに画像を作成できる。また、表現方法を変えたり、友人の見た目に合わせてヘアスタイルなどの特徴を調整できる。

Image Playgroundでは、ChatGPTを使って油絵風やベクターアートなどの新しいスタイルを利用できる。ユーザーは「任意のスタイル」を選び、希望を説明できる。 Image Playgroundは説明や写真をChatGPTに送り、画像を作成する。管理権限はユーザーにあり、許可がない限りChatGPTに情報は共有されない。

Apple Intelligenceによるビジュアルインテリジェンスの画面拡張

Apple Intelligenceを基盤とするビジュアルインテリジェンスがiPhoneの画面に拡張され、ユーザーはあらゆるアプリで画面上の内容を検索・操作できる。

これまではカメラを使い周囲の対象物や場所を認識していたが、今後は画面上の内容についても迅速に処理できるようになる。ユーザーは画面上の情報をChatGPTに質問して詳細を得たり、GoogleやEtsyなどの対応アプリで類似の画像や製品を検索できる。たとえばランプなどの興味のある物をハイライトして、同じものや類似品をオンラインで探せる。

ビジュアルインテリジェンスはイベント情報を認識し、カレンダーへの追加を提案し、Apple Intelligenceが関連データを抽出してイベントを作成する。

ユーザーはスクリーンショットボタンを押すだけで、画面上の内容に対してビジュアルインテリジェンスを利用できる。スクリーンショットを保存・共有するか、ビジュアルインテリジェンスで追加操作を行うかを選べる。

Apple Intelligence基盤モデルのアプリ直接利用と基盤モデルフレームワーク

AppleはApple Intelligenceの基盤モデルをどのアプリからでも直接利用できるようにした。

基盤モデルフレームワークを使うと、開発者は無料のAI推論を活用し、オフライン対応でプライバシー保護されたインテリジェントな体験を提供できる。例えば教育アプリでは、デバイス上のモデルでクラウドAPIを使わずにパーソナライズされたクイズを作成できる。アウトドアアプリでは、オフライン時も自然言語検索を追加できる。

このフレームワークはSwiftにネイティブ対応し、開発者は3行のコードでApple Intelligenceモデルにアクセスできる。ガイド付き生成やツール呼び出しも含まれ、既存アプリへの生成機能の組み込みが容易になる。

Apple Intelligenceによるショートカットの拡張

ショートカットがApple Intelligenceで新たなインテリジェントアクションに対応する。作文ツールのテキスト要約やImage Playgroundの画像生成などの専用アクションが提供される。

ユーザーはデバイス上またはプライベートクラウドでApple Intelligenceモデルを直接利用し、情報のプライバシーを保ったままショートカット内でレスポンスを生成できる。例えば学生は、授業の音声文字起こしとノート内容を比較し、重要項目を追加するショートカットを作成できる。また、レスポンス生成にChatGPTを利用することも可能である。

Apple Intelligenceのアプリ統合と機能強化

Apple Intelligenceは日常のアプリや体験に深く組み込まれる。

Eメール、ウェブサイト、メモの関連アクションを認識し、リマインダーで自動分類できる。

Appleウォレットは店舗や運送業者からのEメールから注文追跡情報を抽出し要約する。これにより、ユーザーは注文情報や進捗通知を一か所で確認できる。

ユーザーはメッセージで投票を作成でき、Apple Intelligenceは投票が有用な場面を検出し提案する。メッセージアプリの「背景」では、Image Playgroundを使い会話内容に合わせた背景を作成しチャットをパーソナライズできる。

Apple Intelligenceにおけるプライバシー保護の仕組み

Apple Intelligenceはユーザープライバシーを保護するよう設計されており、多くの処理はデバイス上で実行される。より大規模なモデルが必要なリクエストには、プライベートクラウドコンピューティングを使用する。これにより、iPhoneのプライバシーとセキュリティを維持したまま処理をクラウドに拡張できる。

ユーザーのデータは保存やAppleとの共有を行わず、リクエストに応じる目的のみに使用される。独立した専門家がAppleシリコン搭載サーバ上で実行されるコードを検証可能で、すでに確認が行われている。